بهترین کارت گرافیک هوش مصنوعی

وقتی صحبت از پردازشهای هوش مصنوعی میشود، انتخاب سختافزار مناسب دیگر فقط یک انتخاب ساده نیست، بلکه تعیینکننده سرعت، دقت و نتیجه نهایی کار است. بهترین کارت گرافیک برای هوش مصنوعی کارتی است که بتواند حجم عظیمی از دادهها را با سرعت بالا پردازش کند، بدون آنکه عملکرد سیستم افت کند. چنین کارتی باید ترکیبی از قدرت، حافظه و معماری هوشمند باشد تا بتواند الگوریتمهای یادگیری عمیق را روان و دقیق اجرا کند. تفاوت میان یک پروژه موفق و یک مدل کند و خطادار، اغلب به همین انتخاب درست برمیگردد.

در ادامه این مطلب از ایران GPU قرار است این موضوع را از جنبههای گوناگون بررسی کنیم و ببینیم دقیقاً چه کارتهایی در دنیای امروز، بهترین گزینه برای AI محسوب میشوند.

چرا کارت گرافیک برای هوش مصنوعی اهمیت دارد؟

هوش مصنوعی بدون کارت گرافیک عملاً سرعت لازم برای پردازش دادهها را ندارد. GPU ها نهتنها محاسبات یادگیری ماشین را تسریع میکنند، بلکه باعث صرفهجویی در انرژی و هزینه نیز میشوند. گزارش دانشگاه استنفورد نشان میدهد عملکرد GPU ها از سال ۲۰۰۳ تاکنون بیش از ۷۰۰۰ برابر افزایش یافته و نسبت قیمت به عملکرد تا ۵۶۰۰ برابر بهتر شده است.

- قدرت پردازش موازی در مقیاس وسیع

GPU ها برخلاف CPU که چند هسته محدود دارد، هزاران هسته کوچک برای انجام محاسبات موازی در خود جای دادهاند. این طراحی به آنها اجازه میدهد تا میلیونها عدد و معادله ریاضی را بهطور همزمان پردازش کنند. همین قابلیت باعث شده GPU ها در آموزش مدلهای AI مانند شبکههای عصبی عمیق، چندین برابر سریعتر از پردازندههای معمولی عمل کنند. درواقع، بیشتر مدلهای بزرگ پنج سال اخیر، مانند ChatGPT، روی هزاران GPU آموزش دیدهاند. (همچنین بخوانید: شبکه های عصبی هوش مصنوعی چیست؟)

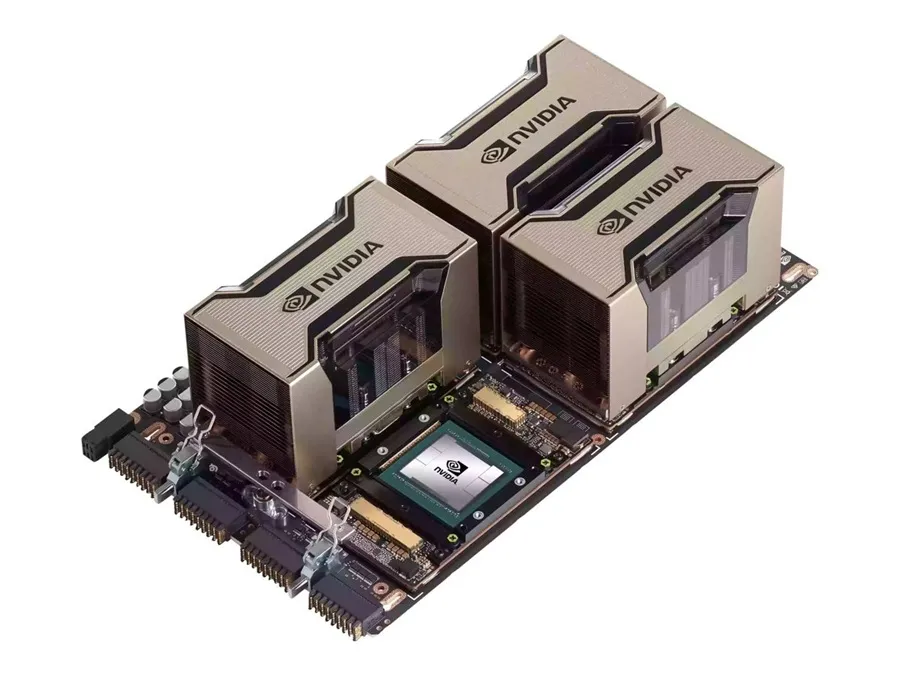

- مقیاسپذیری تا سطح ابررایانه

سیستمهای GPU میتوانند بهصورت خوشهای به هم متصل شوند و قدرتی معادل ابررایانهها ایجاد کنند. فناوریهایی مانند NVLink و شبکه InfiniBand شرکت انویدیا، امکان اتصال صدها جی پی یو را فراهم کردهاند تا بهصورت یک واحد پردازشی کار کنند. نمونه بارز آن، ابرسیستم DGX GH200 است که ۲۵۶ ابرتراشه Grace Hopper را در کنار هم قرار داده و ۱۴۴ ترابایت حافظه اشتراکی در اختیار میگذارد؛ این یعنی مقیاسی که برای مدلهایی مثل GPT-4 ضروری است.

به نقل از NVIDIA

NVLink یک اتصال با سرعت بالا برای GPU ها و CPU هاست که این امکان را برای پردازندهها فراهم میکند تا دادهها را از استخرهای حافظه مشترک با سرعت برقآسا ارسال و دریافت کنند.

- نرمافزارهای تخصصی و گسترده

قدرت GPU تنها در سختافزار آن خلاصه نمیشود. اکوسیستم نرمافزاری شرکتهای سازنده جی پی یوها شامل صدها کتابخانه، زبان برنامهنویسی و ابزار هوش مصنوعی است که توسعهدهندگان را در همه سطوح پشتیبانی میکند. از CUDA گرفته تا cuDNN، TensorRT و NeMo، این ابزارها اجرای مدلهای یادگیری عمیق و مولد را آسانتر و بهینهتر میکنند. همین تنوع نرمافزاری باعث شده GPU های انویدیا در هر سطحی از آموزش، توسعه و استقرار مدلهای AI بهترین انتخاب باشند. (همچنین بخوانید: بهترین GPU برای یادگیری عمیق)

- بازده بالا و صرفهجویی در مصرف انرژی

براساس آزمایشهای MLPerf، GPU های انویدیا در مقایسه با CPU ها، نهتنها چندین برابر سریعتر عمل میکنند؛ بلکه مصرف انرژی و هزینه کل مالکیت (TCO) را نیز تا ۵ برابر کاهش میدهند. هستههای Tensor در نسلهای جدید GPU حتی ۶۰ برابر قدرتمندتر از نسل اول هستند و با فناوری Transformer Engine بهصورت خودکار دقت محاسبات را تنظیم میکنند. نتیجه این پیشرفتها، افزایش ۱۰۰۰ برابری عملکرد GPU ها در پردازش مدلهای هوش مصنوعی طی یک دهه اخیر است.

تفاوت استفاده از سرورهای GPU با کارت گرافیک ساده در کاربردهای هوش مصنوعی

در کاربردهای هوش مصنوعی، تفاوت اصلی میان سرورهای GPU و کارتهای گرافیک ساده در مقیاس و پایداری عملکرد است. کارت گرافیکهای معمولی برای مصارف شخصی یا پروژههای سبک مناسباند، اما سرورهای GPU مخصوص پردازشهای سنگین، آموزش مدلهای بزرگ و کار ۲۴ ساعته طراحی شدهاند. درواقع، سرور GPU همان کارت گرافیک حرفهای است که در محیطی پایدار و بهینه برای محاسبات AI قرار گرفته است. (همچنین بخوانید: سرور GPU چیست؟)

تفاوتهای اصلی این دو عبارتند از:

- سرورهای GPU چندین کارت گرافیک را همزمان بهکار میگیرند، در حالیکه سیستمهای معمولی معمولاً یک کارت دارند.

- سرورهای GPU خنکسازی، تغذیه برق و شبکه داخلی مخصوص دارند تا عملکرد بدون وقفه ارائه دهند.

- کارت گرافیکهای خانگی برای بازی یا طراحی مناسباند، اما سرور GPU برای یادگیری ماشین و مدلهای زبانی بزرگ ساخته شده است.

- از نظر بازده و سرعت پردازش، سرورهای GPU در سطحی بسیار بالاتر قرار میگیرند و برای پروژههای حرفهای هوش مصنوعی بهترین گزینه هستند.

معیارهای انتخاب بهترین کارت گرافیک برای هوش مصنوعی

انتخاب کارت گرافیک مناسب برای پروژه های هوش مصنوعی، بهویژه در یادگیری عمیق، نقشی تعیینکننده در سرعت آموزش مدلها، دقت نتایج و بهرهوری سیستم دارد. در واقع، یک GPU خوب باید میان قدرت پردازش، حافظه، مصرف انرژی و سازگاری نرمافزاری، تعادل دقیقی برقرار کند تا در بلندمدت بهترین عملکرد را ارائه دهد.

- عملکرد و مشخصات فنی

اولین و مهمترین معیار، قدرت پردازش خام است. هرچه تعداد هستههای CUDA و Tensor بیشتر باشد، سرعت اجرای محاسبات ماتریسی و عملیات یادگیری افزایش مییابد. پهنای باند حافظه و شاخص FLOPS نیز شاخصی از توان GPU در پردازش دادههای پیچیده است.

- ظرفیت حافظه

در پروژههای هوش مصنوعی، حافظه ویدیویی (VRAM) تعیین میکند چه مقدار داده و پارامتر مدل بهصورت همزمان در GPU ذخیره و پردازش میشود. مدلهای عمیق مانند GPT یا BERT به حافظهای عظیم برای نگهداری پارامترهایشان نیاز دارند.

به نقل از Pure Storage

VRAM شکلی ویژه از حافظه رم است که در واحدهای پردازش گرافیک (GPU) بهمنظور نگهداری دادههای تصویری برای نمایشگر کامپیوتر استفاده میشود.

- مقیاسپذیری

در پروژههایی که نیاز به آموزش موازی دارند، GPU باید قابلیت اتصال چندگانه ازطریق فناوریهایی مانند NVLink یا InfiniBand را داشته باشد. این ویژگی امکان ساخت سرورهای چند GPU را فراهم میکند که دادهها را سریعتر میان خود رد و بدل میکنند.

- مصرف انرژی و خنکسازی

GPU های پرقدرت معمولاً انرژی زیادی مصرف میکنند؛ بنابراین باید به توان خروجی پاور و سیستم خنکسازی توجه ویژه داشت. مدلهایی مانند NVIDIA A100 با وجود توان بالا، بازده انرژی قابل توجهی دارند.

- پشتیبانی نرمافزاری و اکوسیستم

پشتیبانی نرمافزاری در دنیای AI بسیار حیاتی است. کارتهایی که از فریمورکهایی مثل TensorFlow، PyTorch و CUDA پشتیبانی میکنند، بهترین انتخاب هستند. NVIDIA در این زمینه با ارائه کتابخانههایی مانند cuDNN و TensorRT پیشتاز است.

- معماری و نسل

نسلهای جدید GPU مانند Ampere و Hopper با بهبود در دقت محاسبات، حافظه و ساختار موازیسازی، سرعت یادگیری مدلها را چندین برابر کردهاند. هر نسل جدید معمولاً با فناوریهای مختص هوش مصنوعی مانند Tensor Core بهینه میشود. انتخاب معماری جدیدتر به معنای آیندهنگری و افزایش طول عمر سرمایهگذاری شماست.

- نوع GPU: حرفهای یا خانگی

GPU های حرفهای مانند سری A یا Tesla مخصوص سرورهای AI بوده و دارای ECC Memory، درایورهای بهینه و دوام بالا هستند. در مقابل، کارتهای خانگی (RTX) ارزانتر اما کمتر پایدارند.

برای پروژههای سازمانی و یادگیری عمیق، GPU های حرفهای مانند A100 یا H100 بهترین گزینهاند.

همچنین پیشنهاد میکنیم برای آشنایی و انتخاب بهتر، مقالههای کارت گرافیک H100 چیست و مقایسه کارت گرافیک A100 و H100 را مطالعه کنید.

- قابلیت ارتقا و همخوانی با سرور

پیش از خرید باید اطمینان یافت که GPU با مادربورد، اسلات PCIe و منبع تغذیه سرور سازگار است. برخی GPU ها به خنککننده مایع یا کیس خاص نیاز دارند. همخوانی سختافزاری از بروز گلوگاه و کاهش کارایی سیستم جلوگیری میکند.

| معیار | ویژگی | اهمیت برای پروژههای AI |

| عملکرد فنی | تعداد هستهها، پهنای باند و FLOPS | ⭐⭐⭐⭐⭐ |

| ظرفیت حافظه | حجم VRAM متناسب با مدل | ⭐⭐⭐⭐ |

| مقیاسپذیری | پشتیبانی از NVLink یا چند GPU | ⭐⭐⭐⭐⭐ |

| مصرف انرژی | بهرهوری و خنکسازی بهینه | ⭐⭐⭐ |

| پشتیبانی نرمافزاری | هماهنگی با CUDA و فریمورکهای AI | ⭐⭐⭐⭐⭐ |

| معماری GPU | نسل جدیدتر = سرعت و کارایی بیشتر | ⭐⭐⭐⭐ |

| نوع GPU | حرفهای (A/Tesla) یا خانگی (RTX) | ⭐⭐⭐⭐ |

| سازگاری سختافزاری | هماهنگی با کیس و منبع تغذیه | ⭐⭐⭐ |

برای اجرای مدلهای پیشرفته هوش مصنوعی، انتخاب کارت گرافیک مناسب بیشترین تأثیر را روی سرعت و دقت نتایج دارد. اگر بهدنبال قدرت بالا برای آموزش LLM، پردازش دادههای حجیم یا اجرای مدلهای دیپلرنینگ هستید، سرورهای GPU ایران GPU با کارتهای تخصصی و آمادهبهکار بهترین گزینه برای شماست. همین حالا از صفحه زیر، قدرتمندترین انتخاب را برای پروژهتان داشته باشید.

انواع کارت گرافیک (GPU)

کارتهای گرافیک بهطور کلی در سه دسته اصلی قرار میگیرند:

- گیمینگ (Gaming)

- تخصصی یا ورکاستیشن (Professional/Workstation)

- محاسباتی (Compute یا Data Center)

کارتهای گیمینگ مانند سری NVIDIA GeForce و AMD Radeon برای بازی و کارهای گرافیکی عمومی طراحی شدهاند و عملکرد بالایی در رندر تصاویر دارند. کارتهای ورکاستیشن مثل NVIDIA RTX A6000 یا AMD Radeon Pro برای طراحی سهبعدی، انیمیشن و نرمافزارهای مهندسی بهینه شدهاند. در مقابل، کارتهای محاسباتی مانند NVIDIA A100 یا H100 مخصوص یادگیری عمیق، هوش مصنوعی و تحلیل دادههای سنگین هستند و تمرکز آنها بر توان پردازش موازی و پایداری بالا در محیطهای سروری است. پیشنهاد میکنیم برای آشنایی بیشتر با انواع GPU ، مقاله مرتبط ما را مطالعه کنید.

بهترین کارت گرافیک های NVIDIA برای هوش مصنوعی

وقتی صحبت از هوش مصنوعی و یادگیری عمیق به میان میآید، برند NVIDIA همچنان در صدر انتخابها قرار دارد. این شرکت با عرضه نسلهای مختلف GPU مانند سری Ampere و Ada Lovelace، توانسته نیازهای مختلف پژوهشگران، شرکتها و توسعهدهندگان را پوشش دهد.

در ادامه به معرفی بهترین کارت گرافیک های انویدیا برای هوش مصنوعی در سال 2026 میپردازیم که هر یک متناسب با مقیاس و بودجه متفاوت طراحی شدهاند. همچنین پیشنهاد میکنیم برای آشنایی بیشتر، مقاله انواع سرور GPU را نیز مطالعه کنید.

NVIDIA A100

NVIDIA A100 پرچمدار کارتهای گرافیک مخصوص یادگیری عمیق است. این کارت بر پایه معماری Ampere ساخته شده و با داشتن ۴۳۲ هسته Tensor نسل سوم و حافظه HBM2 تا ۸۰ گیگابایت، یکی از قدرتمندترین گزینهها برای مراکز داده محسوب میشود. A100 با پشتیبانی از فناوری MIG (Multi-Instance GPU) قادر است چندین پردازش مستقل را همزمان و بدون افت عملکرد اجرا کند.

ویژگیها:

- معماری Ampere با توان FP32 تا ۱۹.۵ TFLOPS

- پشتیبانی از Mixed-Precision Training

- حافظهی عظیم HBM2e تا ۸۰ گیگابایت

- فناوری MIG برای اجرای چند مدل همزمان

همچنین بخوانید: کارت گرافیک A100 چیست؟

NVIDIA RTX A6000

RTX A6000 بهعنوان بهترین کارت گرافیک برای هوش مصنوعی نسخه حرفهای از سری Ampere است که تعادل فوقالعادهای بین کارایی و هزینه ارائه میدهد. این کارت برای پروژههای متوسط تا سنگین یادگیری عمیق طراحی شده و با ۴۸ گیگابایت حافظه GDDR6 و ۳۳۶ هسته Tensor عملکرد بسیار پایداری دارد.

ویژگیها:

- معماری Ampere با ۱۰٬۷۵۲ هسته CUDA

- پشتیبانی از Tensor Cores نسل سوم

- حافظه ۴۸ گیگابایتی GDDR6

- سازگار با CUDA، cuDNN و TensorFlow

NVIDIA RTX 4090

RTX 4090 از نسل Ada Lovelace، قویترین کارت گرافیک مصرفی برای AI محسوب میشود. اگرچه مخصوص مصارف گیمینگ ساخته شده، اما با ۱۶٬۳۸۴ هسته CUDA و ۲۴ گیگابایت حافظه GDDR6X، در آموزش مدلهای کوچک تا متوسط، عملکردی فراتر از انتظار دارد.

ویژگیها:

- توان FP32 تا ۸۲.۶ TFLOPS

- پشتیبانی از CUDA و cuDNN

- مناسب برای توسعهدهندگان مستقل و پژوهشهای شخصی

- فاقد NVLink برای اتصال چند GPU

NVIDIA A40

A40 نیز بر پایه معماری Ampere توسعه یافته و گزینهای میانرده برای مراکز داده و توسعهدهندگان نیمهحرفهای است. این کارت با ۴۸ گیگابایت حافظه GDDR6 و ۳۳۶ هسته Tensor، برای آموزش مدلهای بزرگ و اجرای چندین فرآیند همزمان مناسب است.

ویژگیها:

- حافظه ۴۸ گیگابایتی GDDR6

- پشتیبانی کامل از CUDA، cuDNN و TensorRT

- عملکرد بهینه برای پروژههای یادگیری عمیق سازمانی

- تعادل عالی بین قیمت و توان پردازشی

NVIDIA Tesla V100

V100 یکی از محبوبترین کارتهای گرافیک در تاریخ هوش مصنوعی است. این کارت با معماری Volta و ۶۴۰ هسته Tensor، عملکردی قابل اعتماد برای آموزش مدلهای بزرگ دارد. پشتیبانی از NVLink امکان استفاده چند GPU بهصورت همزمان را فراهم میکند و آن را به گزینهای مقرونبهصرفه برای سازمانها تبدیل میسازد.

ویژگیها:

- معماری Volta با حافظه HBM2 تا ۳۲ گیگابایت

- پشتیبانی از Mixed-Precision Training

- NVLink برای افزایش توان چند GPU

- گزینهای اقتصادی برای پروژههای متوسط

| کارت گرافیک | معماری | حافظه | هسته CUDA | هسته Tensor | توان FP32 | رابط NVLink | سال عرضه |

| NVIDIA A100 | Ampere | 40 / 80GB HBM2e | 6,912 | 432 | 19.5 TFLOPS | دارد | 2020 |

| RTX A6000 | Ampere | 48GB GDDR6 | 10,752 | 336 | 38.7 TFLOPS | دارد | 2020 |

| RTX 4090 | Ada Lovelace | 24GB GDDR6X | 16,384 | 512 | 82.6 TFLOPS | ندارد | 2022 |

| NVIDIA A40 | Ampere | 48GB GDDR6 | 10,752 | 336 | 37 TFLOPS | دارد | 2020 |

| NVIDIA V100 | Volta | 16 / 32GB HBM2 | 5,120 | 640 | 14 TFLOPS | دارد | 2017 |

سرور گرافیک ابری چیست؟

سرور گرافیک ابری یا Cloud GPU Server نوعی سرور مجازی است که به کارتهای گرافیک قدرتمند مجهز بوده و از طریق اینترنت در اختیار کاربران قرار میگیرد. این سرورها برای اجرای پروژههای سنگین مانند یادگیری عمیق (Deep Learning)، پردازش هوش مصنوعی (AI)، رندرینگ سهبعدی و تحلیل دادههای بزرگ استفاده میشوند. به جای خرید سختافزار گرانقیمت، میتوانید تنها با پرداخت هزینه ساعتی یا ماهانه، از توان پردازشی کارتهای گرافیک پیشرفته مانند NVIDIA RTX، A100 یا H100 استفاده کنید. سرورهای گرافیک ابری انعطافپذیر، مقیاسپذیر و اقتصادی هستند و این امکان را میدهند که از هر مکان و در هر زمان، پروژههای سنگین خود را با سرعت بالا اجرا کنید.

راهنمای خرید سرور GPU

برای خرید سرور GPU، ابتدا هدف خود را مشخص کنید؛ مثلاً برای هوش مصنوعی، رندرینگ یا تحلیل داده. سپس با توجه به نیاز، کارت گرافیک مناسب مثل NVIDIA A100 یا RTX 4090 را انتخاب کنید. علاوه بر GPU، به RAM، نوع CPU، حافظه SSD یا NVMe و پهنای باند شبکه دقت کنید. در نهایت، خرید از دیتاسنتر معتبر با پشتیبانی قوی و موقعیت جغرافیایی مناسب عملکرد بهتر و هزینه بهینهتری برایتان فراهم میکند.

راهکار ایران GPU

ایران GPU با تکیه بر زیرساختهای پیشرفته و سرورهای اختصاصی جی پی یو، کاملترین سرویس پردازش ابری گرافیکی در ایران را ارائه میدهد. شما میتوانید بدون نیاز به خرید کارت گرافیک گرانقیمت، به قویترین پردازندههای گرافیکی دنیا ازجمله NVIDIA A100، RTX 4090، RTX A6000 و H100 دسترسی پیدا کنید. این سرویس برای محققان، استارتاپها و شرکتهای فعال در حوزه هوش مصنوعی، یادگیری عمیق، رندرینگ و کلانداده طراحی شده و امکاناتی چون Jupyter Notebook ابری، سرور اختصاصی GPU، ابزارهای آماده برنامهنویسی، کاهش زمان محاسبات و دسترسی ۲۴ ساعته را در اختیار شما قرار میدهد.

جمعبندی: بهترین GPU برای هوش مصنوعی

دنیای AI به سرعت در حال رشد است و انتخاب کارت گرافیک مناسب میتواند تفاوتی اساسی میان یک پروژه معمولی و یک موفقیت بزرگ ایجاد کند. هرچه پردازش سریعتر و دقیقتر انجام شود، نتایج نیز هوشمندتر و کارآمدتر خواهند بود. اگر میخواهید مدلهای یادگیری عمیق را در زمان کوتاهتر و با هزینه کمتر آموزش دهید، بهرهگیری از زیرساختهای قدرتمند GPU و بهترین کارت گرافیک برای هوش مصنوعی ، انتخابی هوشمندانه است.

- اگر هدف شما اجرای مدلهای عظیم مانند GPT یا Stable Diffusion است، A100 بهترین انتخاب است.

- برای کارهای تحقیقاتی یا تولید محتوای هوش مصنوعی در مقیاس متوسط، RTX A6000 انتخابی بهینه محسوب میشود.

- RTX 4090 برای توسعهدهندگان مستقل و پژوهشگران مناسب است؛ در حالیکه A40 و V100 گزینههایی اقتصادیتر با کارایی قابل قبول برای محیطهای سازمانیاند.

سوالات متداول

- آیا برای شروع پروژههای هوش مصنوعی به کارت گرافیک حرفهای نیاز دارم؟

بله؛ کارتهای گرافیک حرفهای مانند NVIDIA A100 یا RTX A6000 برای آموزش مدلهای بزرگ و پردازش دادههای سنگین ضروری هستند.

- آیا میتوان با کارتهای گرافیک معمولی مثل RTX 4090 هم مدلهای AI را آموزش داد؟

بله؛ برای پروژههای شخصی یا مدلهای کوچکتر کارتهای مصرفی مانند RTX 4090 انتخاب خوبی محسوب میشوند.

- تفاوت بین کارت گرافیک و سرور GPU چیست؟

سرور GPU چندین کارت حرفهای را در محیطی پایدار و بهینه ترکیب میکند تا بتواند حجم عظیمی از داده را با سرعت بالا پردازش کند.

- چه عواملی در انتخاب بهترین کارت گرافیک برای هوش مصنوعی اهمیت دارد؟

معیارهایی مانند تعداد CUDA Cores، ظرفیت حافظه، نوع معماری (Ampere، Ada، Volta)، پهنای باند حافظه و توان پردازشی (TFLOPs) از مهمترین فاکتورها در انتخاب کارت مناسب هستند.

- آیا استفاده از چند GPU همزمان باعث افزایش سرعت آموزش مدل میشود؟

بله؛ در سیستمهایی که از فناوریهایی مثل NVLink یا Multi-GPU Training پشتیبانی میکنند، میتوان چند کارت گرافیک را برای تقسیم بار محاسباتی بهصورت همزمان به کار گرفت و زمان آموزش مدل را به شکل چشمگیری کاهش داد.